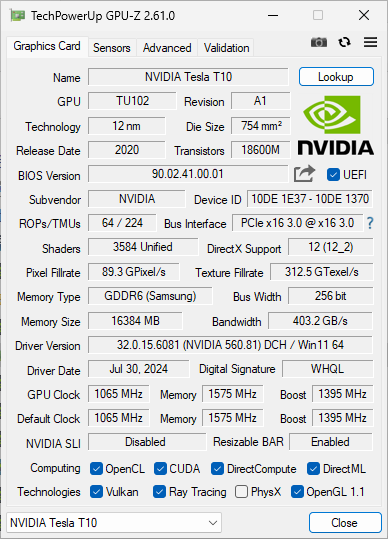

近期在逛中國閒魚時意外發現了一張獨特的顯示卡 – Tesla T10。這款源自專業數據中心的 GPU 原本是 NVIDIA 專門為雲端遊戲服務設計的產品,主要用於 GeForce NOW 雲端遊戲伺服器。現在這些退役的顯示卡進入了二手市場,在中國閒魚上目前約以 1350 人民幣(約 190 美金)價格販售。由於價格便宜,我買了兩張來研究其效能表現。

在 Arista 交換機上部署 Prometheus 監控系統

概述 本文將介紹如何在 Arista 交換機上使用 Docker 容器運行 node_exporter 和 snmp_exporter,以實現透過 Prometheus 監控交換機狀態的功能。

- Cloud

- ...

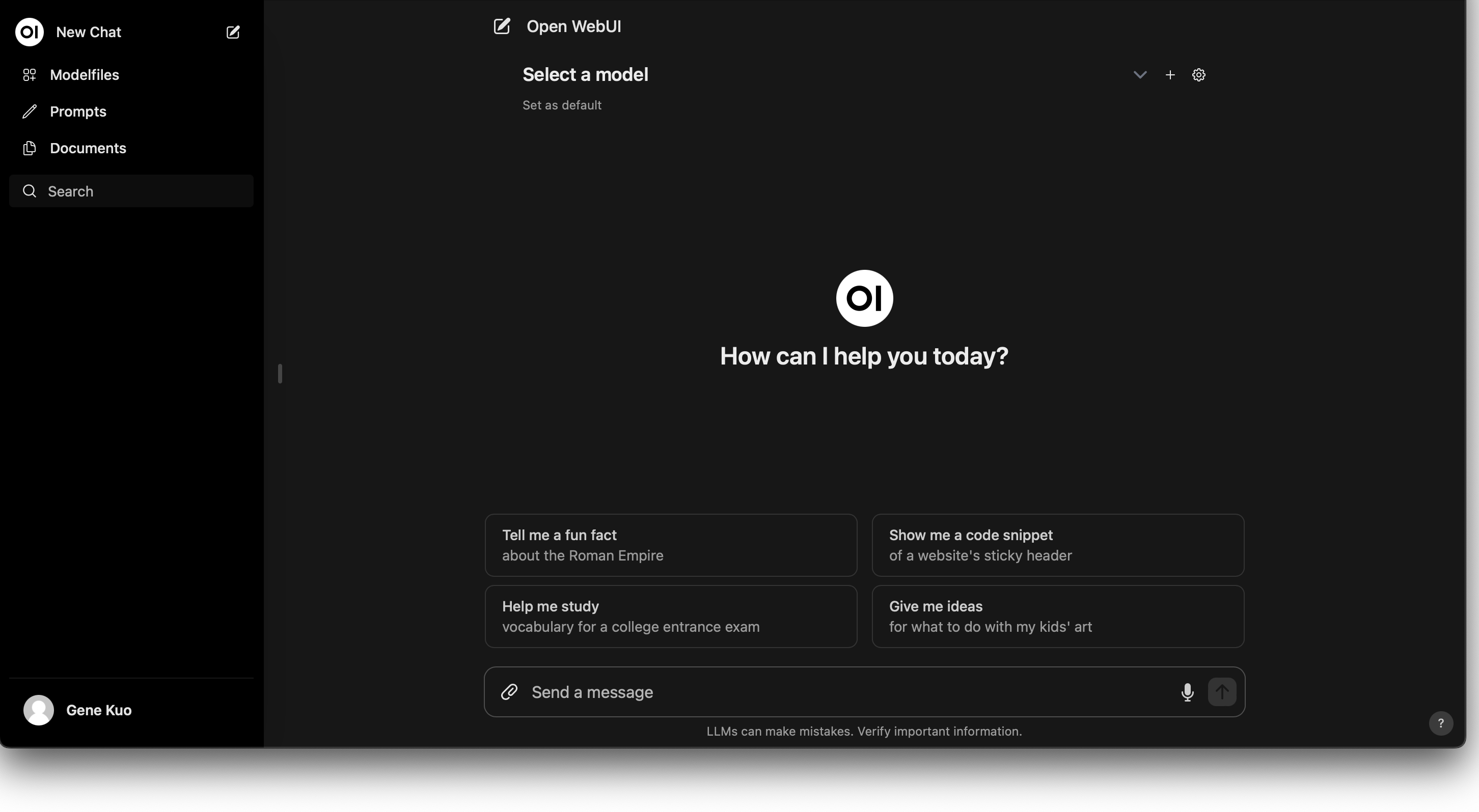

在 Kubernetes 上利用 Nvidia GPU 部署 LLM Chatbot

隨著人工智慧技術的快速發展,越來越多的企業和開發者希望在自己的系統中整合語言模型聊天機器人(LLM Chatbot)。本文旨在引導讀者如何在 Kubernetes 環境中使用 Nvidia GPU,來部署一個高效能的 LLM Chatbot,從安裝必要的驅動和工具到具體的部署步驟,逐一介紹。

如何監控 container 的 PSI 資訊

前言 在上一篇文章中,我們探討了 PSI (Pressure Stall Information) 以及如何監控系統的 PSI 資訊。本文將深入探討如何監控單一 container 的 PSI 資訊。

Linux PSI (Pressure Stall Information) 指標的解讀與應用

前言 當 CPU、記憶體或 I/O 裝置發生競爭時,工作負載會經歷延遲峰值、吞吐量損失,並且面臨 OOM 終止的風險。在沒有準確測量此類競爭的情況下,使用者被迫要麼保守地運用他們的硬體資源,要麼冒險經常遭受因過度設定而引起的中斷。在 Linux kernel 4.20 之後,Linux kernel 加入了 PSI (Pressure Stall Information) 這個資訊,讓使用者可以跟精確的了解到資源不足對整個系統的效能影響。本篇文章將會簡單介紹 PSI 跟如何解讀其資訊。

部署 Charmed Kubernetes with OpenStack Integrator

前言 Charmed Kuberenetes 是 Canonical 提供的 Kubernetes 部署方式,可以透過 juju 將 Kubernetes 部署至各種不同環境。 本篇將介紹如何部署 Charmed Kubernetes 至 OpenStack 上,並且利用 OpenStack Integrator 使用 OpenStack 提供 Persistent Volume 和 Load Balancer 給 Kubernetes 使用。

- Cloud

- ...

快速部署 Kubernetes 叢集:使用 kops 在 OpenStack 上的實踐指南

Kubernetes 提供多種部署選擇,而在眾多工具中,kops 以其易用性及高整合性脫穎而出。本文將深入介紹 kops 工具,並透過實際操作引導讀者在 OpenStack 環境中迅速建立一個 Kubernetes 叢集。

如何挑選適合 Ceph 的 SSD

隨著SSD價格的不斷下降,許多技術愛好者和企業開始考慮使用 Ceph 建立基於 SSD 的儲存池,以追求更高的效能。但要確保 Ceph 達到出色的效能,選擇合適的 SSD 極為關鍵。在本篇中,我們將探討如何選擇適合 Ceph 的 SSD。

AMD GPU 與深度學習:實用教學指南

過去經常聽說 AMD GPU 用於執行深度學習相關軟體非常麻煩,建議有深度學習需求的使用者購買 Nvidia 顯卡。然而,最近 LLM(大型語言模型)很熱門,許多研究單位釋出了基於 LLaMA 的模型,讓我覺得有趣並想測試。我手邊有較多 VRAM 的顯示卡都是 AMD 的,因此決定嘗試使用這些顯示卡來執行。

- Cloud

- ...

Kubernetes Cluster-API 介紹

Kubernetes 在雲原生世界發展這麼多年,也發展出了很多管理其集群生命週期的相關專案,如 kops, Rancher 等。而 VMware 則發起了一個名為 Cluster-API 的專案來利用 Kubernetes 本身的功能管理其他 Kubernetes 集群。本篇文章將會來簡單介紹 Cluster-API 這個專案。